Lo scorso 12 luglio è stato pubblicato sulla Gazzetta ufficiale dell’Unione europea il testo lungamente elaborato del Regolamento sull’Intelligenza artificiale (1689/2924).

Mettere mano attraverso le norme classiche ad un argomento che sfugge alla cognizione antica di spazio e tempo è un’impresa davvero ardua. Sarà un’utopia, ma è un passo utile in un’ottica al momento doverosamente difensiva, che può avere senso se si coniuga ad una inedita ricerca creativa di paradigmi adeguati all’ambiente digitale. Il complesso delle norme e le procedure attuative hanno bisogno di sciacquare i panni in Arno, essendo così evidente la distanza tra la velocità estrema delle neotecnologie e il bagaglio della tradizione costruita sulla polarità di sorvegliare e punire.

Il nuovo testo, che ha richiesto un paio di anni di gestazione e che andrà in vigore in tempi variabili tra 6 e 36 mesi, non sfugge al problema cruciale: quando l’articolato entra nel vivo, l’oggetto sarà (è) già cambiato.

L’Atto in questione si connette al Digital Services Act, al Digital Markets Act, al Data Act, al Digital Governance Act, varati tra il 2022 e il 2023. Una ventata post-liberista (non di sinistra, intendiamoci) ha preso il sopravvento persino in un territorio considerato -a partire dagli anni Novanta del secolo scorso- un luogo di individui appagati dall’essere naviganti apparentemente liberi e privi di ogni remora o controllo. L’illusione durò poco, visto il prepotente arrivo delle Big Tech, ovvero gli oligarchi della rete padroni e signori dell’infosfera.

Ora siamo arrivati oltre i confini del mappamondo, perché algoritmi e intelligenza artificiale generativa scardinano consolidate certezze e sperimentate linee di condotta.

Ad esempio, il ricorrente dibattito sul rapporto tra stato e mercato è spiazzato sia dalla naturale sovranazionalità dei fenomeni sia dal rivolgimento del conosciuto valore di scambio che diviene estrattivo: i dati personali, i profili delle persone, i sensi e i corpi materia primaria per la sorveglianza e la suddivisione in nuove nomenclature di classi e di ceti.

Vedremo che accadrà in concreto, ben consapevoli che il Regolamento IA è una fragile trincea contro l’invasione degli alieni, se siamo di fronte -come sembra- alla transizione tra umano e post-umano.

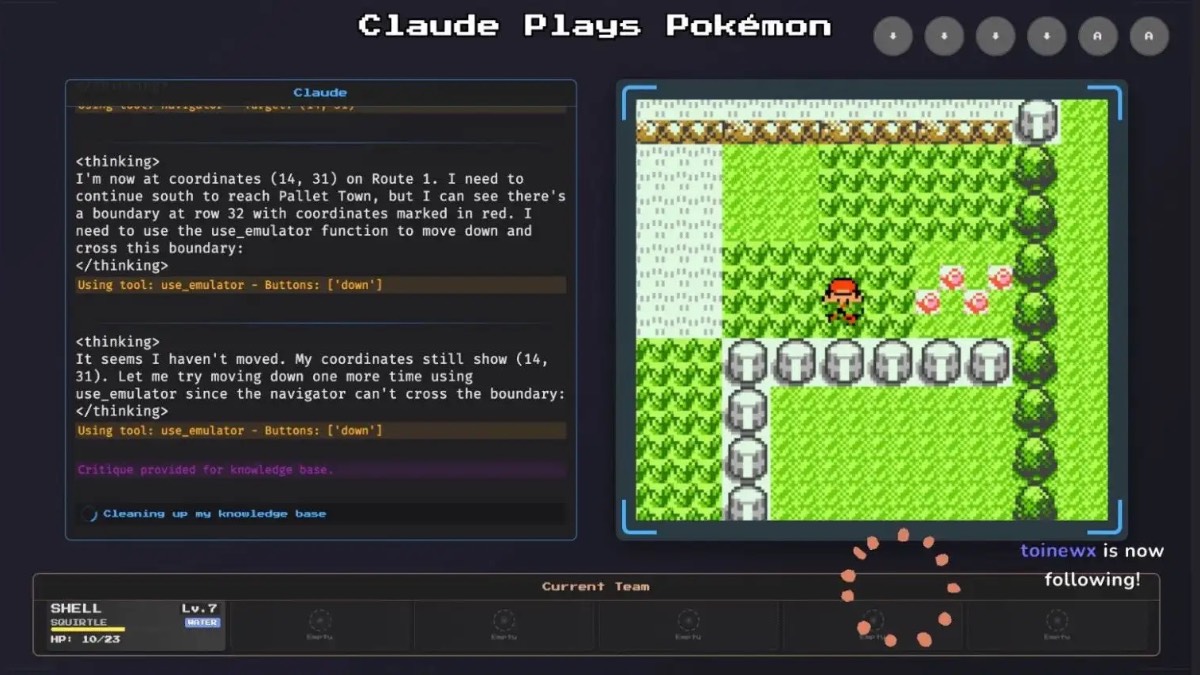

Molto dipende da come e con quali contenuti si rifornisce l’apparato cognitivo dell’IA. Senza l’acquisizione dei miliardi di dati in circolazione l’intelligenza non è né naturale, né artificiale: semplicemente non è.

Tali argomenti sono stati trattati dall’interessante relazione annuale pronunciata lo scorso 3 luglio alla Camera dei deputati dal Garante per la protezione dei dati personali Pasquale Stanzione.

In quella sede si evocava la necessità di introdurre con decisione limiti etici ad un progresso che non può essere lasciato all’indistinta supremazia dell’apparato tecnico. L’«algoretica», riprendendo le parole di Papa Francesco, deve essere una guida, per evitare che si ripresenti alla n potenza un altro caso Oppenheimer. Insomma, il vecchio dibattito tra apocalittici e integrati ha bisogno di essere rivisto e corretto, va aggiunto, dentro una disamina precisa delle novità del Capitale e della sua inedita potenza intellettuale.

Torniamo alla relazione del Garante. Tra i numerosi effetti del ricorso massivo agli algoritmi e all’intelligenza artificiale vi è – si sottolinea- il loro utilizzo esponenziale nelle guerre in corso. Persino rispetto al già arato teatro russo-ucraino (dove la cyberguerra è la normalità), il salto è avvenuto a Gaza. L’altissimo numero di morti e feriti è dovuto anche al sistema Lavender. L’evolutissima macchina messa in campo dall’esercito israeliano prevede l’uccisione di 15/20 civili per ogni obiettivo militare. Vale a dire, l’intelligenza artificiale è lontana da un’astratta perfezione, altro non essendo che la proiezione sofisticata dei difetti umani.

E non finisce qui, come sottolinea il rapporto GPDP (il testo completo è un bel tomo di 269 pagine). Se non si sveglia seriamente il consesso internazionale, piombiamo nel tecnofeudalesimo.